Apple เปิดตัว AI ของบริษัทในชื่อว่า Apple Intelligence ที่แม้ว่าฟีเจอร์และภาพรวมจะน่าสนใจ โดยเฉพาะการรันบนอุปกรณ์หรือ On Device Processing แต่ก็กลายเป็นสร้างข้อจำกัดทำให้รันได้เฉพาะบน iPhone 15 Pro และ iPhone 15 Pro Max ที่ใช้ชิป Apple A17 Pro ส่วน Mac และ iPad ก็ต้องเป็นเครื่องที่ใช้ชิป Apple M1 ขึ้นไปเท่านั้น

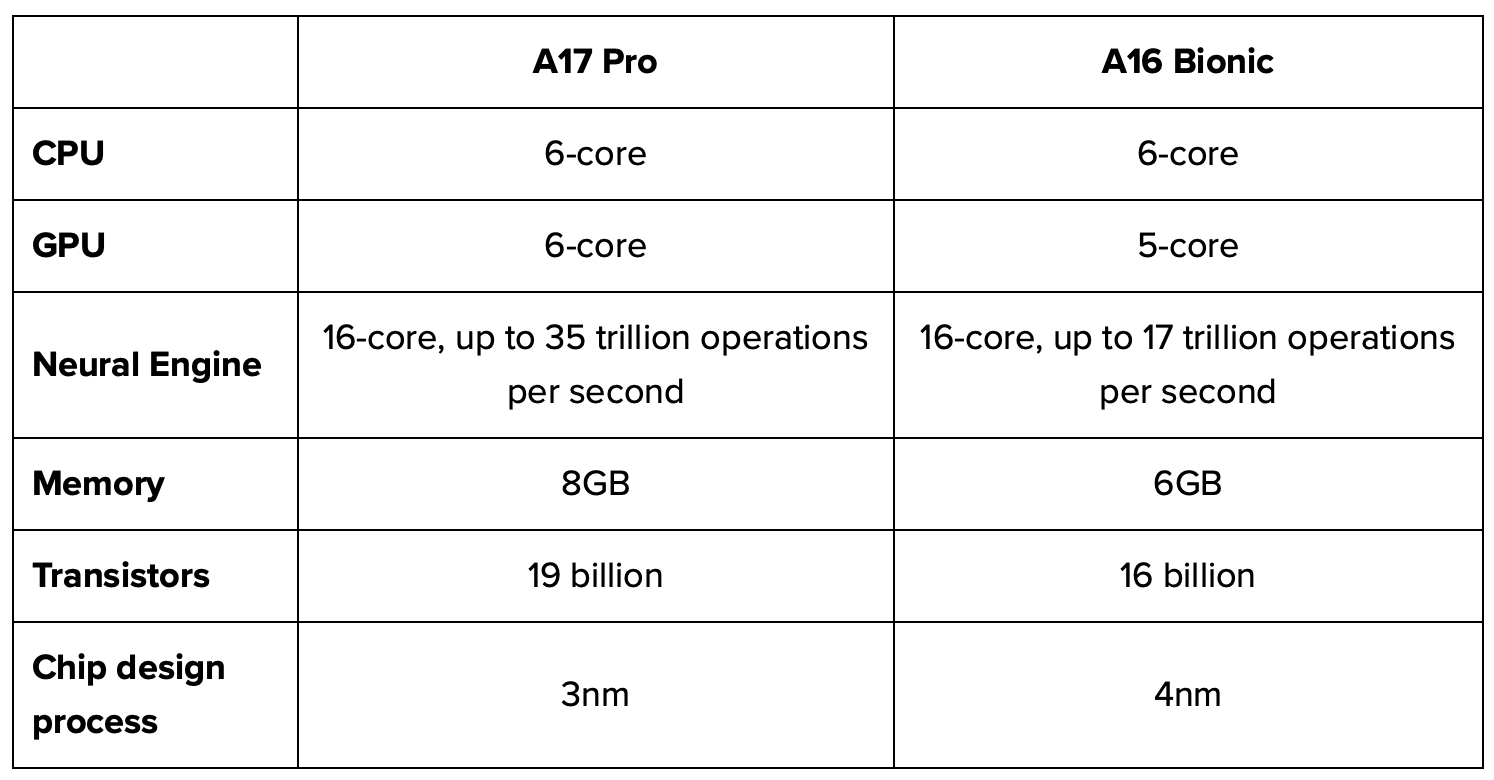

ทำไม iPhone 15 ธรรมดาที่เปิดตัวมาพร้อมกันถึงไม่ได้ Apple Intelligence ? ยังไม่มีคำยืนยันจาก Apple ว่าทำไม แต่หากเทียบจากข้อมูลที่มีก็พบว่าชิป Apple A16 Bionic ที่ใช้บน iPhone 15 นั้นมีแรมเพียง 6GB ซึ่งไม่เพียงพอสำหรับรัน AI บนเครื่องได้ โดย Apple A17 Pro รวมถึง Apple M1 มีแรม 8GB ครับ

iPhone 16 ก็อาจไม่ไหว

กั๊ว หมิง จิ (Ming Chi-Kuo) สายข่าว Apple เจ้าประจำออกมาแสดงความคิดเห็นว่า แม้แต่ iPhone 16 ที่เพิ่มแรมเป็น 8GB ก็อาจจะไม่สามารถรัน Apple Intelligence ได้อย่างเต็มประสิทธิภาพ AI ที่ใช้โมเดลภาษาขนาดใหญ่หรือ large language models (LLMs) จะต้องใช้ทรัพยากรของระบบที่สูงมาก เพื่อให้ทำงานได้เต็มประสิทธิภาพ และนี่คือสิ่งที่ Apple ต้องพิจารณาเมื่อประกาศใช้งาน Apple Intelligence แบบประมวลผลบนอุปกรณ์ไปแล้ว

- On-device LLMs และข้อจำกัดของหน่วยความจำ: LLM คือโมเดลภาษาที่มีความซับซ้อน ออกแบบมาเพื่อทำความเข้าใจและสร้างข้อความที่เหมือนมนุษย์ โมเดลเหล่านี้ต้องการทรัพยากรหน่วยความจำจำนวนมาก เพื่อจัดเก็บพารามิเตอร์และใช้ในการประมวลผลข้อมูลที่ได้รับมาอย่างมีประสิทธิภาพ การประมวลผลบนคลาวด์เป็นข้อได้เปรียบมากกว่าการประมวลผลบนอุปกรณ์ที่มีข้อจำกัดด้านทรัพยากรที่สูงกว่า อย่าง iPhone 15 ที่มีแรม 6GB ก็ไม่เพียงพอแล้ว

- ความคาดหวังของผู้ใช้งาน: หาก Apple ยังคงดึงดันที่จะใช้แรม 8GB บน iPhone ผู้ใช้งานอาจต้องลดความหวังใน Apple Intelligence ลง แม้ว่าที่ผ่านมา Apple จะไม่ได้ใส่แรมมาในอุปกรณ์ที่มากมายเหมือนอุปกรณ์ Android แต่ก็มอบประสบการณ์การใช้งานที่ลื่นไหล แต่นี่เทียบกันไม่ได้ เพราะเป็นเรื่องของ AI แล้ว

- ผลกระทบต่อการพัฒนา AI: การฝึกโมเดล AI และการเพิ่มประสิทธิภาพต้องใช้ทรัพยากรอย่างมาก โดยเฉพาะอย่างยิ่งสำหรับโมเดลขนาดใหญ่ หากหน่วยความจำที่มีอยู่ใน iPhone 16 ไม่เพียงพอสำหรับการพัฒนา AI ก็อาจส่งผลต่อการฝึก AI และกลายเป็นการสร้างข้อจำกัดให้กับฟีเจอร์ของ AI ไปเองได้

- ประสบการณ์การใช้งาน: ในทางปฏิบัติ ข้อจำกัดของแรมจะส่งผลต่อประสิทธิภาพ, การตอบสนองของระบบและแอปพลิเคชันที่ขับเคลื่อนด้วย AI บน iPhone 16 หาก LLM ไม่สามารถใช้งานหน่วยความจำได้อย่างเต็มที่ แรมที่ไม่เพียงพออาจส่งผลให้ความเร็วในการประมวลผลช้าลง รวมถึงไม่สามารถประมวลผลคำสั่งที่มีความซับซ้อนได้ ย่อมส่งผลต่อประสบการณ์การใช้งานโดยตรง

แม้แต่ฟีเจอร์ AI บางอย่างก็ยังต้องการสเปกของฮาร์ดแวร์ที่สูงพอ เพื่อให้ประมวลผล AI หรือ Copilot+ ได้อย่างมีประสิทธิภาพ ในส่วนของ iPhone 16 ซีรีส์ก็ควรที่จะต้องมีฮาร์ดแวร์ที่ดีกว่านี้ เพื่อให้ตอบโจทย์การใช้งานยุค AI ได้อย่างมีประสิทธิภาพมากที่สุดนั่นเอง

ที่มา Dataeconomy