สองสัปดาห์ก่อน นักวิจัยคู่หนึ่งจากมหาวิทยาลัย Standford ได้เผยแพร่งานค้นคว้าวิจัยของตนเกี่ยวกับการใช้รูปภาพหลายพันรูปที่เก็บมาจากเว็บไซต์หาคู่เพื่อฝึกให้ AI หรือปัญญาประดิษฐ์เรียนรู้กระบวนการแยกเพศที่สามหรือเกย์ออกจากชาย/หญิงแท้ผ่านทางรูปถ่ายออกมาสู่สาธารณชน โดย The Economist คือสื่อแรกที่ค้นพบงานวิจัยนี้เข้า ก่อนที่สื่ออื่นๆ จะตามเอามาเป็นประเด็นพาดหัวกันในเวลาต่อมา

แต่งานวิจัยดังกล่าวสามารถทำได้อย่างที่ว่าหรือไม่ ปัญญาประดิษฐ์หรือ AI ที่เรารู้จักกันในปัจจุบันนี้จะสามารถแยกแยะเพศสภาพของคนจากการดูแค่รูปถ่ายแล้วจริงๆ เหรอ? และหากเป็นดังนั้นจริงจะเกิดอะไรขึ้นกับโลกใบนี้? นี่คือคำถามที่ตั้งกันตามมาหลังจากที่งานวิจัยดังกล่าวได้รับการเผยแพร่ออกมาเป็นวงกว้าง และ TheVerge คือเว็บไซต์ที่พาเรามาตีแผ่ความจริงจากงานวิจัยในครั้งนี้

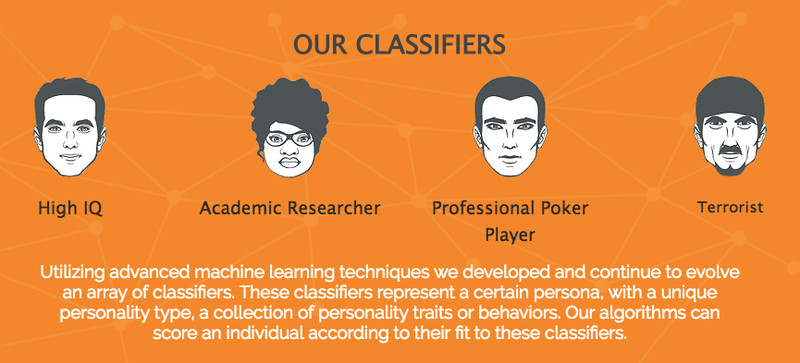

งานวิจัยนี้ได้รับการค้นคว้าและวิจัยโดยดอกเตอร์ Michal Kosinski และ Yilun Wang โดย Kosinski กล่าวว่าจุดประสงค์ของการค้นคว้าวิจัยในครั้งนี้ก็เพื่อเตือนให้ผู้คนได้รู้ถึงอันตรายของ AI หรือปัญญาประดิษฐ์ และเพื่อให้โลกได้ตระหนักว่าอีกไม่นานระบบการจดจำและจำแนกใบหน้าที่เราใช้อยู่นั้นจะไม่ใช่แค่ใช้เพื่อการจำแนกเพศสภาพของผู้คนได้เท่านั้น แต่ยังสามารถใช้เพื่อการจำแนกความแตกต่างทางความคิดเห็นทางการเมือง อาชญากร และแม้แต่ไอคิวของแต่ละบุคคลได้อีกด้วย

ช่วงหนึ่งของผลการทดลองในงานวิจัยระบุว่า “เมื่อให้ AI วิเคราะห์รูปภาพหนึ่งรูปของแต่ละบุคคล [ซอฟต์แวร์] ดังกล่าวสามารถที่จะจำแนกเกย์ในผู้ชายออกจากชายแท้ได้ 81% ของเคสที่ทดลอง ในขณะที่สำหรับผู้หญิงนั้นสามารถจำแนกออกได้ 71%” ซึ่งอัตราความถูกต้องนี้เพิ่มสูงขึ้นไปอีกเมื่อเพิ่มรูปภาพของบุคคลนั้นๆ เข้าไปเป็น 5 รูป โดยเพิ่มขึ้นจาก 81% ในเพศชายเป็น 91% และ 71% ในเพศหญิงเป็น 83%

Advertisement

หากดูจากถ้อยแถลงตรงนี้อาจดูเหมือนว่า AI นั้นสามารถจำแนกเกย์ออกจากชายแท้ได้ถูกถึง 81% จากรูปถ่ายเพียงรูปเดียว แต่ TheVerge มีคำอธิบายที่ขัดแย้งกับคำพูดนั้นและน่าสนใจมากทีเดียว โดย TheVerge บอกว่า จริงๆ แล้วมันไม่ได้เป็นแบบนั้นเสียทีเดียว เพราะ AI ไม่สามารถจำแนกเกย์ออกจากชายแท้ได้ถูกต้อง 81% หากเอารูปมั่วๆ ซั่วๆ คละๆ กันมาให้ดู แต่การทดลองนี้ถูกทดลองโดยรูปถ่ายของคนเป็นคู่ๆ โดยคนหนึ่งในคู่นั้นเป็นชายแท้ และอีกคนในคู่นั้นเป็นเพศที่สาม จากนั้นก็ตั้งคำถาม AI ด้วยคำถามอารมณ์ประมาณว่าคนไหนที่ดูเหมือนเกย์มากกว่ากัน ซึ่งเจ้าปัญญาประดิษฐ์สามารถทายถูกได้ 81% จากทั้งหมดสำหรับเพศชาย และ 71% จากทั้งหมดสำหรับเพศหญิง แต่อย่าลืมว่าโครงสร้างการทดสอบนั้นเอื้อให้ปัญญาประดิษฐ์เริ่มการคาดเดาที่ 50% แล้ว คือชายสองคน หญิงสองคน และคนหนึ่งเป็นชาย/หญิงแท้ ซึ่งแทบไม่ต่างอะไรจากการให้ AI สุ่มเดานั่นล่ะ และถึงแม้ว่าผลของการเดาจะถูกต้องมากจนน่าขนลุก แต่นั่นก็ไม่ได้หมายความว่าปัญญาประดิษฐ์จะสามารถเดาเพศสภาพของคนได้ถูกถึง 81% อย่างที่เข้าใจกัน

Philip Cohen นักสังคมวิทยาจาก University of Maryland ผู้ซึ่งเป็นหนึ่งในคนที่เขียนบล็อกวิพากษ์วิจารณ์เกี่ยวกับงานวิจัยในครั้งนี้กล่าวกับ TheVerge ว่า

“ปัจจุบันนี้มนุษย์เราต้องอยู่กับความกลัวในสถานการณ์ที่ว่าหากคุณมีชีวิตส่วนตัวและสถานภาพทางเพศที่ไม่ต้องการให้ใครรู้ และคุณต้องเดินทางไปยังสนามบินหรืองานแข่งขันกีฬาสักอย่างและต้องถูกเครื่องคอมพิวเตอร์สแกนตัวคุณแล้วสามารถระบุตัวตนของคุณว่าคุณเป็นเกย์หรือชาย/หญิงแท้ออกมาให้คนอื่นเห็น แต่เทคโนโลยีที่ว่านี่ก็ยังไม่มีหลักฐานอะไรมากมายนักมารองรับว่ามันทำได้จริงตามที่ว่า”

Kosinski และ Wang ได้สรุปไว้ท้ายงานวิจัยของพวกเขาว่าเมื่อนำเอารูปภาพ 1000 รูปมาให้ AI ดูแทนการทดสอบจากแค่ 2 รูป แล้วให้ AI เลือกเอาคนที่เป็นเกย์ขึ้นมาแสดง โดยในดาต้าชีตนั้นมี 7% ที่เป็นเกย์ ซึ่งเปรียบได้กับจำนวนประชากรที่เป็นเกย์ในประเทศสหรัฐอเมริกา และเมื่อบอกให้ AI เลือก 100 รูปที่มีแนวโน้มว่าจะเป็นเกย์ออกมา ผลปรากฏว่า AI สามารถเลือกออกมาได้ถูกต้องทั้งสิ้น 43 คน จากทั้งหมด 70 คนที่เป็น โดยอีก 53 คนที่เลือกออกมานั้นเป็นความผิดพลาดของ AI เพราะคนเหล่านั้นเป็นชายแท้ และเมื่อตีคำถามให้เป็นวงแคบไปอีก โดยให้เลือก 10 จาก 100 คนในนั้นที่มีโอกาสเป็นเกย์มากที่สุดขึ้นมา AI สามารถเลือกได้ถูกต้อง 9 คน

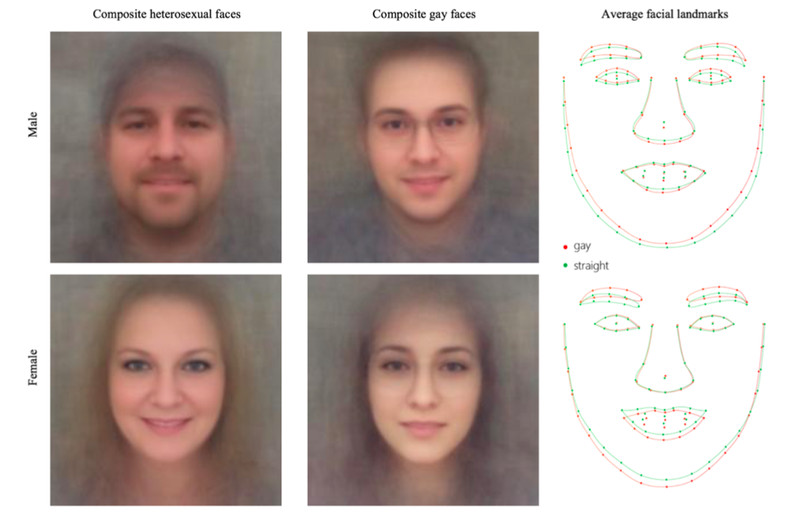

ยังไม่เป็นที่แน่ชัดว่า AI นั้นใช้หลักเกณฑ์อะไรกันแน่ในการจำแนกประชากรที่เป็นเพศที่สามออกจากชาย/หญิงแท้ทั่วไป แต่ Kosinski และ Wang มีสมมติฐานว่า AI แยกเพศสภาพของคนออกจากโครงสร้างของใบหน้าว่าในใบหน้าของชายหนุ่มคนหนึ่งมีโครงสร้างของผู้หญิงมากน้อยเพียงใด และเช่นเดียวกันกับกรณีของใบหน้าของผู้หญิงว่ามีโครงสร้างของผู้ชายอยู่ในนั้นเพียงใด ซึ่งนั่นทำให้เกิดจุดบกพร่องอันยิ่งใหญ่ในตรรกะของ AI จุดที่ว่านั้นก็คือการแสดงออกทางสีหน้าของคนๆ หนึ่งที่อาจทำให้ AI สับสนในตรรกะที่ใช้ในการตรวจวัดนั่นเอง

นี่เป็นปัจจัยสำคัญที่ก่อให้เกิดข้อพิพากษ์ที่มาขัดแย้งงานวิจัยนี้อย่างชัดเจน โดยตามที่ Greggor Mattson อาจารย์ภาคสังคมวิทยาจากวิทยาลัย Oberlin กล่าวไว้ในบล็อกว่าสิ่งๆ นี้ชี้ให้เห็นความบกพร่องของงานวิจัยชิ้นนี้ เพราะลำพังรูปภาพที่นำมาใช้นั้นก็มีความเอนเอียงแล้ว เพราะมันเป็นรูปภาพที่เก็บมาจากเว็บไซต์หาคู่และถูกเลือกขึ้นมาโพสโดยผู้ใช้งานในเว็บไซต์นั้นๆ เพื่อหาคู่ที่เป็นเพศที่ตนต้องการทั้งนั้น ซึ่งนั่นก็เป็นประหนึ่งการระบุเพศสภาพให้กับตัวเองผ่านทางภาพถ่ายจากอากัปกริยาทางสีหน้าและลักษณะท่าทางแล้ว ยังไม่รวมถึงความจริงที่ว่ากลุ่มคนตัวอย่างที่ใช้ในงานวิจัยนั้นล้วนแล้วแต่เป็นคนผิวขาวที่เป็นเกย์ทั้งหมด ไม่มีพวกที่จัดตัวเองในกลุ่มไบเซ็กชวลหรือกลุ่มคนที่แปลงเพศแล้วในนั้นเลย ซึ่งทำให้มันง่ายต่อการจำแนกตามตรรกะของ AI นั่นเอง

งานวิจัยนี้ยังเป็นประเด็นถกเถียงกันอยู่ในวงกว้าง และ APPDISQUS เองเห็นว่าเป็นประเด็นที่น่าสนใจ ที่คิดๆ ไปแล้วทั้งน่าขนลุกและน่าตกใจที่ปัญญาประดิษฐ์นั้นอาจไม่ไกลเกินจินตนาการที่เราเคยเห็นในภาพยนตร์กันแล้วหากต่อไปมีคนสามารถพิสูจน์ความสามารถของมันออกมาเป็นทฤษฎีที่ไร้ขอพิพากษ์โดยสิ้นเชิง

อย่างไรก็ตามการทดลองโดยการเอาปัญญาอัฉริยะเหล่านี้มาสร้างความตระหนกให้เกิดขึ้นกับคนกลุ่มๆ หนึ่งนั้นดูจะเป็นอะไรที่ไม่สมควรนักจนเกิดเป็นกระแสวิพากษ์วิจารณ์กันอยู่ ณ ขณะนี้ เพราะหากเจ้า AI เกิดทำได้ตามที่ว่ามาจริงๆ โดยไร้ข้อกังขา โลกเราคงเกิดความโกลาหลขึ้นไม่น้อยหากเครื่องมือเหล่านี้ตกไปอยู่ในการใช้งานของกลุ่มใดกลุ่มหนึ่งที่ไม่ควร

เราคงต้องจับตาดูความก้าวล้ำของ Artificial Intelligence (AI) หรือปัญญาประดิษฐ์อัจฉริยะนี้กันต่อไป

เพื่อนๆ สามารถตามอ่านข้อพิพากษ์ของงานวิจัยนี้จาก The Verge ได้โดยละเอียดจากลิงก์ที่เราใส่ไว้ในอ้างอิงเนื้อหาบทความ

และหากเพื่อนๆ ต้องการอ่านบทความน่าสนใจเพิ่มเติม APPDISQUS ได้คัดเลือกมาให้แล้วตามลิงก์ข้างล่างนี้เลย